Meta 將代碼以開放存取人工智能的名義發布 圖片綁定,它預測數據之間的關係類似於人們如何感知或想像他們的環境。 雖然 Midjourney、Stable Diffusion 和 DALL-E 2 等圖像生成器將文字綁定到圖像,讓您可以僅基於文本描述創建視覺場景,但 ImageBind 不止於此。 它可以鏈接文本、圖像或視頻、音頻、3D 測量值、溫度數據和運動數據——並且不需要抓住每一個機會進行預訓練。 這是一個框架的早期階段,最終將能夠從簡單的輸入生成複雜的環境,例如文本提示、圖像或音頻(或它們的組合)。

您可以將 ImageBind 視為機器學習對人類學習的近似。 例如,如果您站在繁忙的城市街道等動態環境中,您的大腦(大部分是無意識地)會吸收視覺、聲音和其他感官感受,以獲取有關過往車輛、高樓、天氣等信息. 人類和其他動物已經進化到可以處理這些數據以獲得我們的遺傳優勢:生存和傳遞我們的 DNA。 (你對周圍環境了解得越多,你就越能避免危險並適應你的環境以更好地生存和發展)。 隨著計算機越來越接近於模仿動物的多感官連接,它們可以使用這些連接僅基於有限的數據片段生成完全真實的場景。

因此,雖然您可能會使用 Midjourney 來創建“穿著甘道夫服裝的巴吉度獵犬在沙灘球上保持平衡”並獲得該奇怪場景的相對逼真的照片,但像 ImageBind 這樣的多模態 AI 工具最終可能會創建與狗相關的視頻聲音,包括詳細的客廳、室溫以及狗和場景中其他人的確切位置。 “這創造了一個極好的機會,可以通過將靜態圖像與音頻提示相結合來從靜態圖像創建動畫,”Meta 研究人員在他們面向開發人員的博客中指出。 “例如,創作者可以將圖像與鬧鐘和打鳴的公雞結合起來,並使用音頻提示來分割公雞或鬧鐘的聲音來分割時鐘並在視頻序列中製作動畫。”

至於這款新玩具還能做些什麼,它清楚地指向了 Meta 的核心野心之一:VR、混合現實和元空間。 例如,想像一下未來的耳機可以即時構建完全實現的 3D 場景(帶有聲音、動作等)。 或者虛擬遊戲開發者最終可以使用它來為自己節省設計過程中的大部分艱苦工作。 同樣,內容創建者可以僅基於文本、圖像或音頻創建具有逼真的配樂和動作的沉浸式視頻。 還很容易想像像 ImageBind 這樣的工具如何通過生成實時多媒體描述來幫助有視覺或聽覺障礙的人更好地了解他們的環境,從而在可訪問性方面打開新的大門。

也很有趣: 基於人工智能的最佳工具

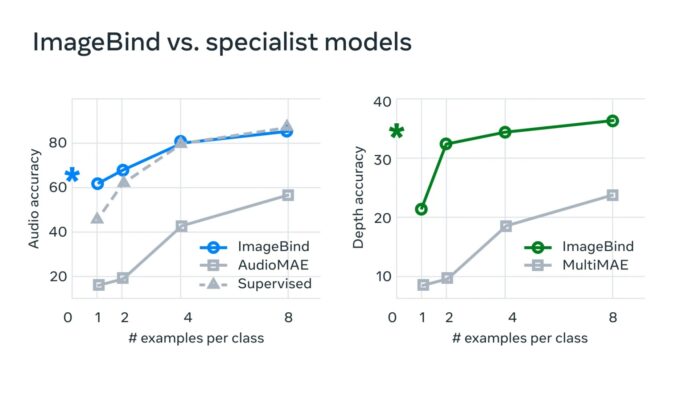

“在典型的人工智能係統中,每個相關模態都有一個特定的嵌入(即可以表示數據及其在機器學習中的關係的數字向量),”Meta 說。 “ImageBind 表明,可以為多種模態創建一個通用的嵌入空間,而無需使用每個單獨的模態組合對數據進行訓練。 這很重要,因為研究人員無法創建包含例如來自繁忙城市街道的音頻數據和熱數據,或深度數據和海邊懸崖文本描述的樣本的數據集。”

Meta 認為,這項技術最終會超越目前的六種“感官”,可以這麼說。 “雖然我們在當前的研究中調查了六種模式,但我們相信引入連接盡可能多的感官的新模式——例如觸覺、語音、嗅覺和 fMRI 大腦信號——將允許更豐富的以人為中心的人工智能模型。” 有興趣探索這個新沙盒的開發人員可以從深入研究 Meta 的開源代碼開始。

另請閱讀: