週四,研究人員 Microsoft 宣布了一種名為 VALL-E 的新人工智慧 (AI) 模型,在提供三秒音訊樣本時可以準確模仿人聲。一旦學習到特定的聲音,VALL-E 就可以合成該人說話的音頻,同時保留說話者的情緒基調。

它的作者建議 VALL-E 可用於高質量的文本到語音、語音編輯,其中一個人的錄音可以從文本轉錄中編輯和更改(讓他們說出他們最初沒有說的話),以及用於結合其他生成式 AI 模型創建音頻內容,例如 GPT-3.

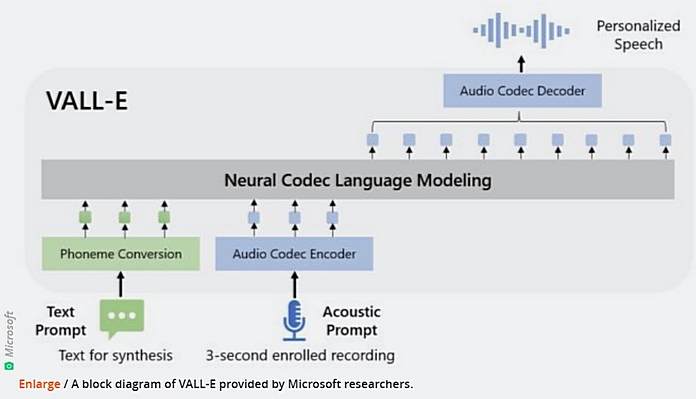

Microsoft 將VALL-E 稱為“神經編解碼器語言模型”,它基於Meta 於2022 年 月宣布的一種名為EnCodec 的技術。與通常透過操縱波形來合成語音的其他文字轉語音方法不同,VALL -E 產生離散音訊來自文字和聲音提示的編解碼器程式碼。它基本上分析一個人的聲音,透過EnCodec 將這些資訊分解為離散的組件(稱為「令牌」),並使用訓練資料來匹配它「知道」的聲音,如果它在外面說其他短語的話,它會是什麼樣子。三秒樣本的。

Microsoft 在 Meta 編譯的名為 LibriLight 的音訊庫上訓練了 VALL-E 的語音合成能力。它包含來自 60 多名播音員的 7 小時的英語廣播,大部分摘自公開的 LibriVox 有聲讀物。

除了保留播音員的音質和情緒基調外,VALL-E還可以模擬音訊樣本的「聲學環境」。例如,如果樣本是從電話交談中獲得的,則合成的音訊輸出將模擬電話交談的聲學和頻率特性。還有樣品 Microsoft 證明 VALL-E 可以產生聲音音色變化。

也許是由於 VALL-E 具有促進欺詐和欺騙的潛在能力, Microsoft 尚未提供VALL-E程式碼供其他人進行實驗,因此我們無法測試其功能。研究人員似乎意識到這項技術可能帶來的潛在社會危害。他們在文章的結論中寫道:

“因為 VALL-E 可以合成保留說話者身份的語音,它可能會帶來模型濫用的潛在風險,例如欺騙語音識別或冒充特定說話者。 為了降低這種風險,將建立一個識別模型來區分音頻片段是否是使用 VALL-E 合成的。”

你可以幫助烏克蘭對抗俄羅斯侵略者。 最好的方法是通過以下方式向烏克蘭武裝部隊捐款 拯救生命 或通過官方頁面 NBU.

另請閱讀: